Siete líneas de investigación sobre inteligencia artificial generativa en educación que deberíamos estar abordando

Un mapa para orientar la investigación en un campo que avanza más rápido que nuestra capacidad de comprenderlo

El problema no es si usar IA, sino cómo investigar con ella

Llevamos más de dos años debatiendo sobre inteligencia artificial generativa en educación. Las posiciones oscilan entre el entusiasmo acrítico y el rechazo preventivo, pero hay algo que escasea: investigación rigurosa sobre cómo estas tecnologías transforman la producción de conocimiento educativo.

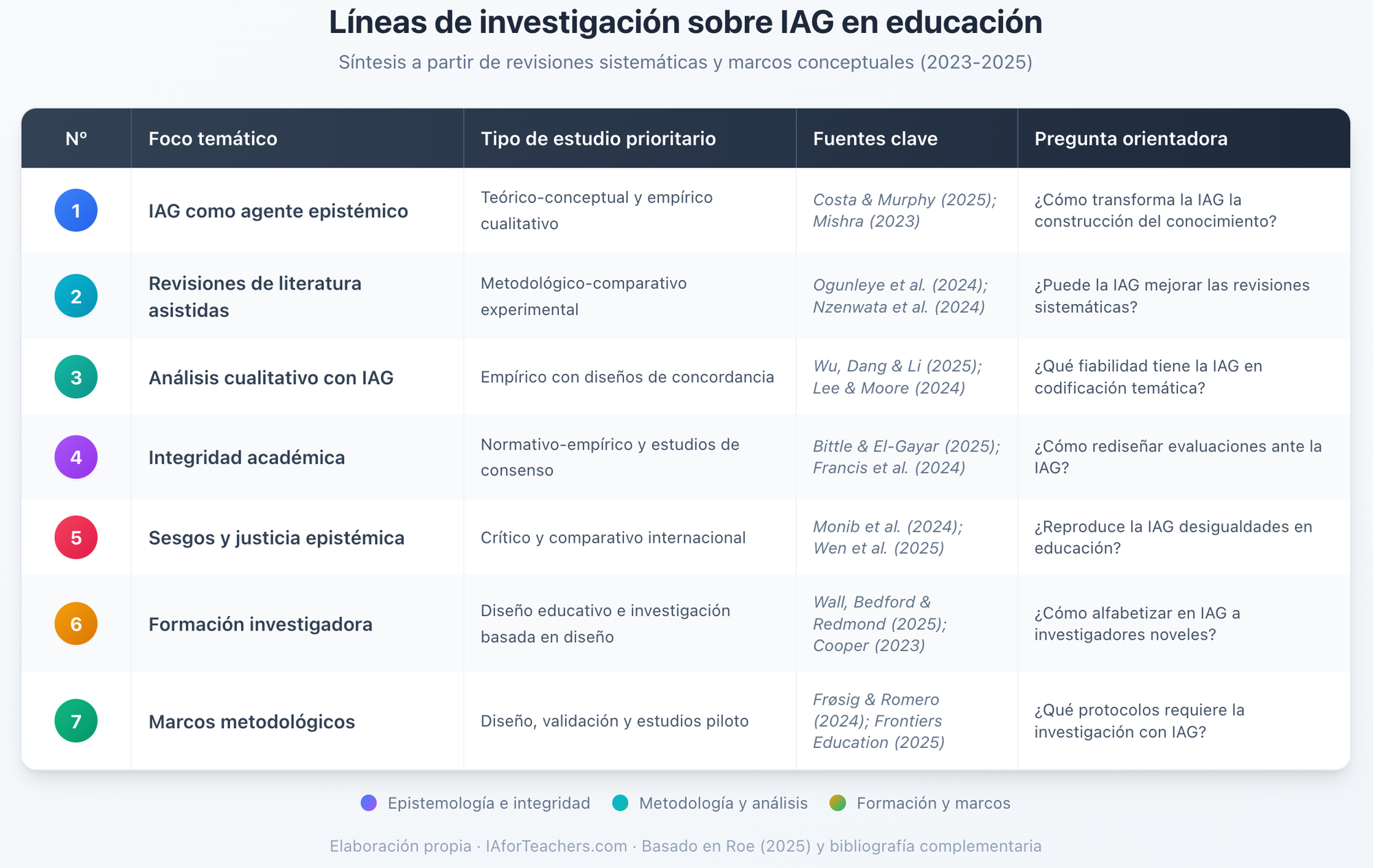

He dedicado las últimas semanas a revisar la literatura científica reciente, centrándome en revisiones sistemáticas y estudios publicados entre 2023 y 2025 en revistas como Frontiers in Education, Education Sciences, PeerJ Computer Science y la serie Cambridge Elements. El resultado es un mapa provisional de siete líneas de investigación que, en mi opinión, deberían estructurar la agenda científica del campo.

No pretendo ofrecer respuestas definitivas. Más bien, quiero compartir las preguntas que me parecen más urgentes y los fundamentos bibliográficos que las sostienen.

Línea 1: La inteligencia artificial como agente epistémico

La conceptualización dominante de la IAG como «herramienta» resulta epistemológicamente limitada. Cuando un sistema generativo interviene en la formulación de preguntas de investigación, en la revisión de literatura o en el análisis de datos, no estamos simplemente «usando una herramienta». Estamos estableciendo una forma de cognición distribuida donde diferentes funciones se reparten entre agentes humanos y artificiales.

Frøsig y Romero (2024) proponen el concepto de «inteligencia híbrida» para caracterizar esta relación. El marco resulta sugerente, pero plantea interrogantes que apenas hemos comenzado a explorar: ¿en qué fases del proceso investigador la intervención de la IA introduce ganancias sin comprometer la validez epistémica? ¿Cómo se modifican nuestros procesos de pensamiento cuando interactuamos iterativamente con estos sistemas?

Costa y Murphy (2025), desde la pedagogía crítica, advierten que las tecnologías generativas pueden reducir nuestra capacidad de concebir conocimiento propio. La preservación de la agencia de pensamiento no es un lujo romántico: es condición de posibilidad de la investigación genuina.

Línea 2: Validez y sesgos en revisiones de literatura asistidas

La revisión sistemática constituye un género metodológico con criterios de calidad bien establecidos. La introducción de la IAG en este proceso plantea interrogantes técnicos y epistemológicos que requieren investigación empírica.

Ogunleye et al. (2024), tras analizar 355 publicaciones, concluyen que no existen directrices consensuadas para estas prácticas. Nguyen y Truong (2025), en su análisis bibliométrico, identifican la necesidad urgente de marcos regulatorios. Pero más allá de la regulación, necesitamos estudios comparativos: ¿cómo se comparan, en términos de exhaustividad y sesgo de selección, las revisiones realizadas por equipos humanos frente a las asistidas por IA?

Una pregunta particularmente incómoda: ¿reproduce la IAG un canon bibliográfico anglocéntrico que margina la producción académica en otras lenguas? Si la respuesta es afirmativa, y hay indicios de que lo es, las implicaciones para la diversidad epistemológica son serias.

Línea 3: Análisis cualitativo con asistencia de IA generativa

El análisis cualitativo de datos educativos descansa tradicionalmente en la capacidad interpretativa del investigador. La codificación temática, el análisis de discurso, el análisis narrativo son prácticas donde la subjetividad disciplinada constituye un recurso metodológico, no un defecto a eliminar.

¿Qué ocurre cuando introducimos sistemas generativos en estos procesos? Las preguntas son múltiples: ¿es fiable la codificación temática realizada con apoyo de modelos de lenguaje? ¿Cómo influye la formulación de las instrucciones en la construcción de categorías analíticas? ¿Puede la IA captar dimensiones semánticas implícitas que requieren conocimiento cultural específico?

No tengo respuestas definitivas, pero sospecho que la cuestión no es si usar o no usar IA en análisis cualitativo, sino para qué funciones específicas resulta apropiada y cuáles deben permanecer bajo control humano exclusivo.

Línea 4: Integridad académica y nuevos modelos de autoría

Bittle y El-Gayar (2025), tras revisar 41 estudios, concluyen que la IAG facilita nuevas formas de deshonestidad académica al tiempo que puede servir como herramienta legítima si se implementa con transparencia. El problema central no es el uso, sino el uso opaco.

Cooper (2023) añade una dimensión inquietante: estos sistemas pueden presentarse como autoridades sin respaldar adecuadamente sus afirmaciones. Generan textos que simulan competencia sin comprensión genuina, lo que dificulta la verificación y puede inducir a errores.

Las preguntas que emergen son complejas. ¿Cómo debe declararse el uso de IAG en artículos científicos? ¿Qué prácticas constituyen mala praxis y cuáles resultan aceptables? Y quizá la más desafiante: ¿cómo redefinimos autoría, originalidad y contribución intelectual cuando el texto emerge de una colaboración humano-máquina?

Línea 5: Justicia epistémica y sesgos algorítmicos

Los modelos generativos reproducen estructuras de poder epistémico presentes en sus datos de entrenamiento. La literatura científica en inglés, las tradiciones académicas del Norte Global y determinados enfoques teóricos resultan sobrerrepresentados.

Weng y Fu (2025) documentan cómo la IAG puede tanto amplificar como mitigar desigualdades según cómo se implemente. Pero la pregunta más incómoda permanece abierta: ¿qué responsabilidades éticas asumimos los investigadores cuando utilizamos sistemas con sesgos conocidos?

Para quienes trabajamos en español u otras lenguas no hegemónicas, la cuestión tiene implicaciones prácticas inmediatas. Si la IA privilegia sistemáticamente fuentes anglófonas, ¿estamos contribuyendo inadvertidamente a la marginación de nuestras propias tradiciones académicas?

Línea 6: Formación de investigadores para el uso crítico

Wu, Dang y Li (2025) analizaron 99 estudios sobre actitudes y comportamientos de uso entre estudiantes y docentes. Sus hallazgos revelan una variabilidad considerable: las percepciones dependen del contexto institucional, la disciplina y las experiencias previas con tecnologías educativas.

Wall, Bedford y Redmond (2025) proponen principios que resultan transferibles a la formación investigadora: enseñar a utilizar las herramientas, fomentar el discernimiento crítico sobre sus limitaciones, formar de manera integral atendiendo tanto a competencias técnicas como a valores éticos.

La pregunta práctica es cómo integrar esta formación en los programas de doctorado y máster. No basta con talleres instrumentales sobre «cómo usar ChatGPT». Necesitamos desarrollar simultáneamente habilidades de uso y capacidad crítica, lo cual requiere enfoques pedagógicos más sofisticados.

Línea 7: Marcos metodológicos verificables

Quizá la línea más urgente. El modelo de gobernanza «vivo» propuesto en Frontiers in Education (2025) ofrece orientación valiosa: los marcos deben combinar principios éticos con flexibilidad para adaptarse a la rápida evolución tecnológica.

Sin embargo, a diferencia de los marcos institucionales, los marcos metodológicos para investigación requieren operacionalización precisa. ¿Qué significa exactamente «transparencia» en el uso de IAG? ¿Cómo documentamos el proceso de manera que permita evaluación y replicación? ¿Qué mecanismos garantizan que el control humano sobre decisiones epistémicas críticas se preserve efectivamente?

No tenemos todavía respuestas consensuadas. Pero la construcción de estos marcos constituye, en mi opinión, una tarea colectiva urgente.

Hacia una agenda de investigación compartida

Este mapa no pretende ser exhaustivo ni definitivo. Es una propuesta de estructuración del campo basada en literatura verificada, orientada a facilitar la conversación entre quienes compartimos la preocupación por integrar la IAG en la investigación educativa de manera rigurosa y responsable.

Cada una de estas líneas admite desarrollos diversos: estudios teórico-conceptuales, investigaciones empíricas comparativas, diseños educativos, análisis críticos. Lo que necesitamos es pasar de las opiniones a la evidencia, del debate polarizado a la indagación sistemática.

En las próximas semanas iré profundizando en algunas de estas líneas. Si trabajas en alguna de ellas o tienes experiencias que compartir, me encantará conocerlas.

¿Te ha resultado útil este análisis que he realizado para ti? Compártelo con colegas que puedan estar interesados. Y si quieres seguir la conversación, suscríbete a este espacio que no te defraudará.

Referencias citadas

Bittle, K., y El-Gayar, O. (2025). Generative AI and academic integrity in higher education: A systematic review and research agenda. Information, 16(4), 296.

Cooper, B. (2023). Examining science education in ChatGPT: An exploratory study of generative artificial intelligence. Journal of Science Education and Technology, 32(4), 514-526.

Costa, C., y Murphy, M. (2025). The promise and challenges of generative AI in education. Educational Philosophy and Theory.

Frøsig, P., y Romero, M. (2024). Teacher agency in the age of generative AI: Towards a framework of hybrid intelligence for learning design. arXiv.

Nguyen, T., y Truong, M. (2025). Trends and emerging themes in the effects of generative artificial intelligence in education. Eurasia Journal of Mathematics, Science and Technology Education.

Ogunleye, O., et al. (2024). A systematic review of generative AI for teaching and learning practice. Education Sciences, 14(11), 1263.

Wall, T., Bedford, S., y Redmond, P. (2025). Generative artificial intelligence in education: Initial principles developed from practitioner reflexive research. Journal of Educational Research.

Weng, M., y Fu, J. (2025). Generative AI in language education: Bridging divide and fostering inclusivity. International Journal of Technology in Education.

Wu, F., Dang, Y., y Li, M. (2025). A systematic review of responses, attitudes and utilization behaviours on generative AI for teaching and learning in higher education. Behavioral Sciences, 15(4), 467.